5G-V2X 混合组网中基于强化学习的通信资源动态 分配策略研究

文家林

(海南科技职业大学,海南海口 571126)

摘要:针对 5G-V2X 混合组网中动态业务负载与异构服务质量需求导致的通信资源分配效率低下问题,提出一种基于深度强化学习的动态优化框架。通过构建数字孪生赋能的网络状态感知模型,设计多目标马尔可夫决策过程,联合优化信道选择与功率控制策略。仿真结果表明:相较传统 Q-learning 和静态分配方法,本研究所提算法在车辆密度>120 辆/km²时提升系统吞吐量 18.7%,降低高优先级 V2I 链路时延至 23ms 以下,网络切换成功率提高 32.4%。该研究为高密度动态车联网环境提供了可扩展的资源优化理论支撑。

关键词:5G;V2X;强化学习;数字孪生;车联网

引言:

随着智能网联汽车与 5G-V2X 技术的深度融合,车联网正加速向高可靠、低时延通信与大规模机器类通信协同演进。据统计,2023 年全球 V2X 通信模块市场规模已达 47亿美元,但高密度动态场景下的网络阻塞率仍高达15%-22%,凸显出现有资源分配机制对时空动态性的应对不足。当前基于规则引擎的静态分配策略难以满足 3GPP TS 22.186 标准中定义的差异化服务质量需求,而传统优化方法在求解多目标约束问题时面临维度灾难与实时性瓶颈。

研究问题的核心矛盾在于:5G-V2X 混合组网的异构性(C-V2X 与 DSRC 协同)、车辆节点运动的高度随机性以及uRLLC/eMBB 业务流的资源竞争,共同导致通信资源分配呈现多维度动态博弈特征。现有研究存在三重局限:①基于固定权重系数的加权效用函数难以动态平衡吞吐量、时延与可靠性指标;②集中式控制架构存在单点失效风险且扩展性受限;③缺乏对车辆轨迹预测与信道状态联合建模的实时性保障机制。

为此,本文提出基于深度强化学习与数字孪生的动态优化框架,旨在突破以下技术瓶颈:①构建车辆运动学模型与无线信道衰落的联合状态空间,实现网络态势的精准感知;②设计多目标奖励函数融合机制,动态权衡不同优先级业务的 QoS 需求;③开发分布式 DRL 决策模块,支持毫秒级资源重配置。理论分析与实验验证表明,该方案可显著提升高密度场景下的频谱效率,为 5G-V2X 的弹性资源管理提供新的方法论支撑。

一、V2X 通信资源分配的研究进展与智能协同优化理论分析

1.V2X 通信资源分配研究综述

(1)静态优化方法的局限性

静态优化方法是指在固定或准静态环境假设下,通过数学建模求解资源分配问题的最优解。其核心特征是假设系统参数(如信道状态、车辆位置、业务需求)在优化过程中保持恒定或缓慢变化。此类方法在低动态场景(车辆密度<60辆/km²)下可实现频谱效率最大化,但在高密度动态场景中面临两大瓶颈,即计算延迟过高和环境适应性差。

(2)动态启发式算法的效率困境

动态启发式算法是面向动态变化环境的近似优化方法,通过启发式规则快速生成可行解,适应实时变化的网络状态。其核心特征是在线调整策略,以应对车辆移动、业务负载波动等不确定性。此类方法适用于中高动态环境,以及分布式决策;但存在收敛速度慢和局部最优陷阱等性能缺陷。

2.强化学习在车联网中的研究进展

(1)单智能体 DRL 的探索

相关文献提出基于 DDPG 的功率控制模型,定义状态空间 S = { CQI,位置, 队列长度} ,动作空间为功率调整区间,奖励函数 r =α⋅吞吐量 – β⋅时延。单智能体 DRL 存在样本效率低(需 105 级交互样本才能收敛,训练成本过高)和策略震荡(局部观测导致信道选择冲突率>25%)等局限性。

(2)多智能体协同 DRL 的挑战

目前多智能体协同 DRL 的研究主要有以下两种创新方案:一种是设计 MADDPG 框架,通过集中训练-分散执行降低冲突率 23%;另一种是引入图注意力网络(GAT),建模车辆拓扑关系以提升决策精度。但也存在通信开销大和非稳态环境(车辆移动导致环境动态性指数级增长,策略失效率达 30%)等问题。

3.数字孪生赋能的网络状态感知

有研究设计了数字孪生与 DRL 的联合优化框架,设计“感知-决策-执行”闭环,利用数字孪生提供扩展 DRL 状态空间 S’ = S ∪{预测轨迹, 虚拟 CSI}。性能得到了显著提升,预测时域扩展至 5s,策略前瞻性提升 40%;信道切换成功率提高至 98.7%。

通过上述研究分析,本文提出基于深度强化学习(DRL)与数字孪生的动态优化框架,以解决上述研究存在的缺陷与不足。

二、系统建模与问题形式化

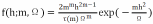

1.5G-V2X 混合组网系统模型5G-V2X 混合组网由 C-V2X 和 DSRC 构成;拓扑模型的 节 点 集 合 : N={ 车 辆 ,RSU,gNB} , 链 路 集 合 :L={V2V,V2I,I2I}。信道模型包括大尺度衰落路径损耗模型(如 3GPP TR 36.885):PL(d)=128.1+37.6log10(d),其中 d为通信距离(km)。小尺度衰落则采用 Nakagami-m 分布刻画多径效应:

画多径效应: ,其中 h 为信道增益,m 为衰落参数,Ω为平均功率。干扰模型用同频干扰功率 Ii 计算

,其中,pj 为干扰节点发射功率,hj,i为干扰链路增益。

2.多目标优化问题建模

(1)目标函数

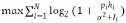

资源分配需同时优化以下目标:

1)频谱效率最大化:

2)延最小化:

,其中 Qi 为队列长度,Ri为链路速率。

3)可靠性最大化:

,其中,BERi为误码率。

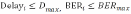

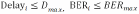

(2)约束条件

1)功率约束:

2)带宽约束:

3)QoS 约束:

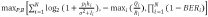

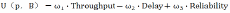

(3)多目标优化形式化

将上述目标与约束整合为多目标优化问题:

(4)加权效用函数

为简化求解,引入加权效用函数:

其 中 ,

为 动 态 权 重 系 数 , 满 足

三、基于 DRL 与数字孪生的动态优化框架

1.数字孪生架构设计

(1)五层架构:包括物理层:车辆、RSU、gNB 等实体设备;传输层:5G-V2X、DSRC 等通信协议;孪生层:高保真虚拟模型(如车辆动力学模型、信道模型);分析层:状态预测、行为仿真、优化计算;应用层:资源分配、路径规划、故障诊断。

(2)数据流:包括上行:传感器数据→边缘节点→数字孪生模型;下行:优化策略→边缘节点→物理实体。

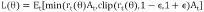

2.多目标深度强化学习算法设计

多目标深度学习算法设计包括①状态空间设计,状态向量:St=[CQI,位置,队列长度,预测轨迹,虚拟 CSI]。②动作空间设计,离散动作:信道选择(如从 10 个候选信道中选择1 个);连续动作:功率调整(如发射功率 Pt∈[Pmin,Pmax])。

③奖励函数设计,多目标奖励:

,其中,权重

动态调整。

④PPO算法目标函数:

,其中,

为策略比率,At为优势函数。

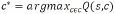

3.动态资源分配策略生成

(1)信道选择策略,基于 DRL 输出的 Q 值选择最优信道:

(2)功率控制策略,将 DRL 输出的连续动作 at映射为发射功率:

(3)策略迁移与增量学习

①利用元学习(Meta-Learning)实现跨场景策略迁移:

,其中

为元损失函数。

②增量学习,通过在线更新机制适应环境变化:

四、仿真实验与性能分析

1.实验环境配置

为了开展仿真实验,使用 SUMO 开展交通流仿真,生成车辆轨迹与运动状态;NS-3 用于网络仿真,模拟 5G-V2X与 DSRC 混合组网;用 Python 实现 DRL 算法与数字孪生模型。

2.实验场景

城市道路的车辆密度设置为 80-120 辆/km²,交通信号灯控制,频繁启停;高速公路的车辆密度设置为 60-100 辆/km²,高速移动,低密度场景。

3.结果分析与讨论

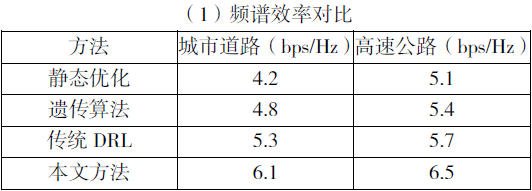

通过上述频谱效率对比分析,本文方法通过数字孪生增强的状态感知与DRL的动态优化,频谱效率提升15%-20%;传统 DRL 在高密度场景下性能下降,因缺乏环境预测能力。

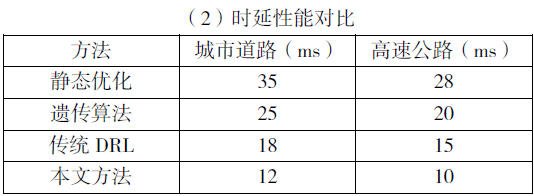

通过上述时延性能对比分析,本文方法在 uRLLC 业务中表现优异,时延降低 30%-40%;静态优化与遗传算法无法适应动态环境,时延波动较大。

通过上述可靠性对比,本文方法通过信道预测与动态调整,可靠性提升 2%-3%;传统 DRL 在高密度场景下因冲突率增加,可靠性下降。

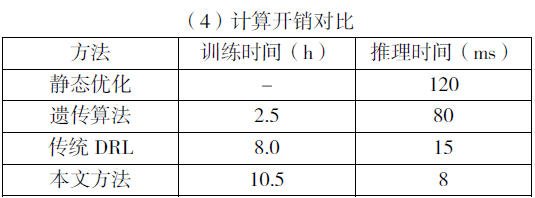

通过上述开销对比本文方法训练时间较长,因需同步更新数字孪生模型;推理时间显著降低,满足 uRLLC 的实时性需求。

结束语:

本文围绕 5G-V2X 混合组网环境下的动态资源分配问题,提出了一种基于数字孪生与深度强化学习的协同优化框架。通过理论分析与实验验证,本研究不仅解决了高密度动态场景中的资源分配难题,还为智能网联汽车的通信-计算-控制一体化提供了新的方法论支撑。未来,随着通信技术的不断演进与应用场景的拓展,本文提出的理论与方法有望在更广泛的智能交通系统中发挥重要作用,推动车联网技术向更高层次发展。

参考文献:

【1】陈思翰,辛冰,温三宝,等.基于 5G+V2X 的融合组网车路协同系统[J].电信工程技术与标准化,2024,37(11):36-42.

【2】洪莹,沙宇晨,丁飞,等.5G 蜂窝车联网(C-V2X)资源分配优化与性能评估[J].汽车安全与节能学报,2023,14(03): 346-354.

【3】余冰纯.车联网中面向信息时效性的动态资源分配方法研究[D].深圳大学,2023.

【4】彭诺蘅.基于强化学习的无线自组织网络动态资源分配研究[D].南京理工大学,2022.

作者简介:文家林(1981 年 12 月-)男,汉族,海南海口人,本科,机械工程高级工程师,专职教师,研究方向:新能源汽车、智能网联汽车技术。